catleya

Madmaxista

- Desde

- 14 Jun 2012

- Mensajes

- 5.836

- Reputación

- 13.257

Peor que el reconocimiento facial: la próxima gran indignación por la privacidad

Por True Publica

Global Research, 14 de octubre de 2019

TruePublica 13 octubre 2019

Región: Europa

Tema: Inteligencia , Estado policial y derechos civiles

1

3 0

12

Los activistas de la privacidad han advertido sobre el uso de una " epidemia de reconocimiento facial " en todo el Reino Unido. Esto, por supuesto, siguió a la epidemia de CCTV que lo condujo en primer lugar. Una investigación realizada por Big Brother Watch, el grupo de campaña de libertades civiles, encontró que los principales promotores inmobiliarios, centros comerciales, museos, centros de conferencias y casinos estaban utilizando la tecnología en el Reino Unido. La policía lo usa, con tasas de fracaso sorprendentemente altas. Pero ahora llega un nuevo campo de batalla en la guerra de privacidad: sistemas de detección de mentiras.

En TruePublica, hemos advertido sobre el surgimiento del estado tecno-Stasi del Reino Unido, donde la tecnología se aprovecha y se usa contra la población civil sin ningún debate o de hecho ningún marco legal real. Pero si crees que el reconocimiento facial es lo suficientemente malo, entonces el próximo escándalo contra nuestras libertades civiles ya se está desplegando, nuevamente, sin debate público. Esta vez, la sociedad civil se está probando con sistemas de detección de mentiras impulsados por IA, y esto es mucho peor que el reconocimiento facial con implicaciones más desafiantes.

Hay literalmente cientos de estudios que han examinado el ' efecto Pinnochio ' de los humanos y una búsqueda rápida en línea proporciona muchas respuestas. En términos generales, se entiende que todos decimos una o dos grandes mentiras al día y algunas 'mentiras piadosas', y luego estamos expuestos a cientos de otros colectivamente. Las mentiras van desde ser socialmente educados hasta razones encubiertas para el avance personal o, de hecho, dañar activamente a otros. Pero entonces, todos lo sabemos. Por eso confiamos en unos y no en otros. Es por eso que algunas personas realmente inadecuadas e inútiles obtienen buenos trabajos y otras no. Mentir es un juego que todos jugamos, todos los días de nuestras vidas y hemos aprendido a navegarlo. Algunos mejores que otros.

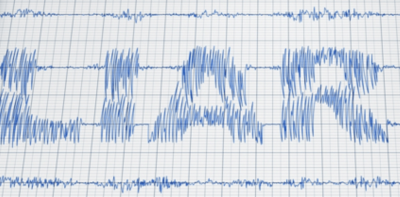

La tecnología ha intentado resolver el problema de la mentira, o encontrar la verdad, donde una situación grave lo exige. En casos de delitos graves, los polígrafos serían geniales si funcionaran pero no lo hacen. Y aquí hay otra mentira. Inventado en 1921, el Polígrafo ha puesto a muchos tras las rejas en los Estados Unidos. Algunos han sido ejecutados injustamente por eso. Y, sin embargo, a pesar de las afirmaciones de 90% de validez de los defensores del polígrafo, el Consejo Nacional de Investigaciónno ha encontrado evidencia de efectividad y dos tercios de la comunidad científica que tienen los antecedentes necesarios para evaluar los procedimientos poligráficos consideran que la poligrafía es poco más que pseudociencia. Y, sin embargo, cada año se realizan alrededor de 2.5 millones de exámenes de polígrafo en los EE. UU. En una industria con un valor de $ 2.5 mil millones. No se trata de llegar a la verdad, se trata del dinero, como dicen.

El Reino Unido comenzó a usar polígrafos que se han usado en delincuentes sensuales desde 2014, y en enero de 2019, el gobierno anunció planes para usarlo en abusadores domésticos bajo libertad condicional. Por lo tanto, es posible que también se alarme al saber que una nueva ola de sistemas de detección de mentiras no solo está en camino, sino que ya están en uso.

Muchas startups ahora afirman que una nueva y poderosa generación de herramientas de detección de mentiras no solo funcionan sino que se usan activamente. Quieren que creamos que un detector de mentiras prácticamente infalible es, al igual que el polígrafo en la década de 1920, a la vuelta de la esquina.

La consecuencia es que estos nuevos sistemas están siendo adquiridos por las fuerzas policiales y las agencias estatales desesperadas por mantenerse a la vanguardia de posibles violaciones de la seguridad nacional. Peor aún, ahora también están siendo utilizados por compañías de seguros, funcionarios de asistencia social y pronto en el horizonte, por los empleadores. Por ejemplo, el sitio web de Converus promueve un producto llamado EyeDetect y hace afirmaciones de una precisión del 90% tal como lo hicieron los polígrafos. Su página de inicio dice:

La extinción de la privacidad y la seguridad personal a través de la biometría y la sociedad sin efectivo

El FT publicó una historia el mes pasado sobre el tema:

Martin Innes , director del Instituto de Investigación de Crimen y Seguridad de la Universidad de Cardiff, Reino Unido, dice que es "escéptico" de que el sistema prediga de manera confiable los delitos a nivel individual. La herramienta probablemente será más útil para localizar comunidades en riesgo en general, dice.

La policía de Northumbria está llevando a cabo un plan piloto que utiliza EyeDetect para medir la rehabilitación de los delincuentes sensuales. No pasará mucho tiempo antes de que tales sistemas se amplíen hasta el punto de que el uso de sistemas de detección de mentiras de IA se pueda usar en todos los asuntos de la toma de decisiones diaria.

En un reciente artículo de Guardian: " La carrera para crear un detector de mentiras perfecto ", el autor pregunta:

El otro problema es que los polígrafos se han utilizado para condenas por décadas. El primero fue en 1935 y desde entonces han seguido cientos de exoneraciones , y al final de este largo experimento, que ha demostrado ser un fracaso, su uso continúa y, lo que es peor, se está implementando en el Reino Unido.

La detección de mentiras es una frontera completamente nueva y las nuevas empresas se dirigen a ella en una era de seguridad nacional y doméstica, una forma de combatir los crecientes costos de vigilar las calles y luego buscar formas de tomar decisiones sobre la salud (cuestionarios sobre ejercicio, alimentos, alcohol ?), educación (áreas de captación?), empleo (¿razones para dejar el último empleador?) y todo tipo de vida normal.

Un número creciente de proyectos está utilizando IA para combinar múltiples fuentes de evidencia en una sola medida de engaño. ¿Te imaginas un sistema que te dé una calificación de engaño? El aprendizaje automático está acelerando la investigación del engaño al detectar patrones nunca vistos en una gran cantidad de datos. El artículo de The Guardian destaca que los científicos de la Universidad de Maryland, por ejemplo, han desarrollado un software que afirman que puede detectar el engaño de las imágenes de la corte con un 88% de precisión.

Posteriormente , Frontex , la agencia fronteriza de la UE, llevó a cabo los ensayos y ahora está financiando un sistema competitivo llamado iBorderCtrl, con su propia guardia de fronteras virtual. Un aspecto de iBorderCtrl se basa en Silent Talker, una tecnología que ha estado en desarrollo en la Universidad Metropolitana de Manchester desde principios de la década de 2000. Silent Talker utiliza un modelo de IA para analizar más de 40 tipos de micro-gestos en la cara y la cabeza; solo necesita una cámara y una conexión a internet para funcionar. Este sistema tiene una tasa de precisión del 75%, y el equipo que desarrolló el algoritmo de IA llegó a decir que "No sabemos cómo funciona".

En julio de este año, el controvertido juicio de la Policía Metropolitana de Londres sobre tecnología de reconocimiento facial para detectar sospechosos no funcionó el 81% del tiempo , según los investigadores. Los investigadores de la Universidad de Essex dijeron que los problemas eran tan graves que el uso del reconocimiento facial por parte del Met debería detenerse de inmediato. Y, sin embargo, este sistema todavía está en funcionamiento y lo utilizan varias fuerzas policiales y contratistas privados.

Las tasas de precisión del 80-90% afirmadas por EyeDetect parecen impresionantes, pero aplicadas a la escala de un cruce fronterizo, llevarían a miles de personas inocentes a ser señaladas erróneamente por cada amenaza genuina que identificara. También podría significar que dos de cada 10 terroristas se deslizan fácilmente. Podría decirse que, por el contrario, ocho de cada diez no lo hacen, pero la evidencia de sistemas menos sofisticados como el reconocimiento facial nos dice que ese no será el caso.

Por True Publica

Global Research, 14 de octubre de 2019

TruePublica 13 octubre 2019

Región: Europa

Tema: Inteligencia , Estado policial y derechos civiles

1

3 0

12

Los activistas de la privacidad han advertido sobre el uso de una " epidemia de reconocimiento facial " en todo el Reino Unido. Esto, por supuesto, siguió a la epidemia de CCTV que lo condujo en primer lugar. Una investigación realizada por Big Brother Watch, el grupo de campaña de libertades civiles, encontró que los principales promotores inmobiliarios, centros comerciales, museos, centros de conferencias y casinos estaban utilizando la tecnología en el Reino Unido. La policía lo usa, con tasas de fracaso sorprendentemente altas. Pero ahora llega un nuevo campo de batalla en la guerra de privacidad: sistemas de detección de mentiras.

En TruePublica, hemos advertido sobre el surgimiento del estado tecno-Stasi del Reino Unido, donde la tecnología se aprovecha y se usa contra la población civil sin ningún debate o de hecho ningún marco legal real. Pero si crees que el reconocimiento facial es lo suficientemente malo, entonces el próximo escándalo contra nuestras libertades civiles ya se está desplegando, nuevamente, sin debate público. Esta vez, la sociedad civil se está probando con sistemas de detección de mentiras impulsados por IA, y esto es mucho peor que el reconocimiento facial con implicaciones más desafiantes.

Hay literalmente cientos de estudios que han examinado el ' efecto Pinnochio ' de los humanos y una búsqueda rápida en línea proporciona muchas respuestas. En términos generales, se entiende que todos decimos una o dos grandes mentiras al día y algunas 'mentiras piadosas', y luego estamos expuestos a cientos de otros colectivamente. Las mentiras van desde ser socialmente educados hasta razones encubiertas para el avance personal o, de hecho, dañar activamente a otros. Pero entonces, todos lo sabemos. Por eso confiamos en unos y no en otros. Es por eso que algunas personas realmente inadecuadas e inútiles obtienen buenos trabajos y otras no. Mentir es un juego que todos jugamos, todos los días de nuestras vidas y hemos aprendido a navegarlo. Algunos mejores que otros.

La tecnología ha intentado resolver el problema de la mentira, o encontrar la verdad, donde una situación grave lo exige. En casos de delitos graves, los polígrafos serían geniales si funcionaran pero no lo hacen. Y aquí hay otra mentira. Inventado en 1921, el Polígrafo ha puesto a muchos tras las rejas en los Estados Unidos. Algunos han sido ejecutados injustamente por eso. Y, sin embargo, a pesar de las afirmaciones de 90% de validez de los defensores del polígrafo, el Consejo Nacional de Investigaciónno ha encontrado evidencia de efectividad y dos tercios de la comunidad científica que tienen los antecedentes necesarios para evaluar los procedimientos poligráficos consideran que la poligrafía es poco más que pseudociencia. Y, sin embargo, cada año se realizan alrededor de 2.5 millones de exámenes de polígrafo en los EE. UU. En una industria con un valor de $ 2.5 mil millones. No se trata de llegar a la verdad, se trata del dinero, como dicen.

El Reino Unido comenzó a usar polígrafos que se han usado en delincuentes sensuales desde 2014, y en enero de 2019, el gobierno anunció planes para usarlo en abusadores domésticos bajo libertad condicional. Por lo tanto, es posible que también se alarme al saber que una nueva ola de sistemas de detección de mentiras no solo está en camino, sino que ya están en uso.

Muchas startups ahora afirman que una nueva y poderosa generación de herramientas de detección de mentiras no solo funcionan sino que se usan activamente. Quieren que creamos que un detector de mentiras prácticamente infalible es, al igual que el polígrafo en la década de 1920, a la vuelta de la esquina.

La consecuencia es que estos nuevos sistemas están siendo adquiridos por las fuerzas policiales y las agencias estatales desesperadas por mantenerse a la vanguardia de posibles violaciones de la seguridad nacional. Peor aún, ahora también están siendo utilizados por compañías de seguros, funcionarios de asistencia social y pronto en el horizonte, por los empleadores. Por ejemplo, el sitio web de Converus promueve un producto llamado EyeDetect y hace afirmaciones de una precisión del 90% tal como lo hicieron los polígrafos. Su página de inicio dice:

Mientras tanto, el sistema se está utilizando en el mundo real.“ EyeDetect® es un detector de mentiras de próxima generación. Mide cambios sutiles en el ojo para detectar el engaño. EyeDetect se utiliza para evaluar a los solicitantes de empleo, empleados, personas en libertad condicional e pagapensiones, así como a las fuerzas del orden y al personal de seguridad pública , para protegerse contra la corrupción y el crimen. También se utiliza para realizar pruebas de diagnóstico (un solo problema) para casos penales o civiles. Cuando la verdad es importante, obtenga una segunda opinión con EyeDetect ".

Y antes de que te des cuenta, eso es exactamente lo que surgió.“ EyeDetect , ha sido utilizado por FedEx en Panamá y Uber en México para descartar conductores con antecedentes penales, y por la agencia de calificación crediticia Experian, que evalúa a su personal en Colombia para asegurarse de que no estén manipulando la base de datos de la compañía para obtener préstamos para miembros de la familia. Otros clientes de EyeDetect incluyen el gobierno de Afganistán, McDonald's y docenas de departamentos de policía locales en los Estados Unidos. Pronto, los programas de detección de mentiras a gran escala podrían llegar a las fronteras de los EE. UU. Y la Unión Europea, donde marcarían a los viajeros potencialmente engañosos para realizar más preguntas ".

La extinción de la privacidad y la seguridad personal a través de la biometría y la sociedad sin efectivo

El FT publicó una historia el mes pasado sobre el tema:

Por supuesto, el uso de la tecnología no es nada nuevo, lo que es nuevo es que estos sistemas requieren datos masivos para funcionar en primer lugar. Un sistema ya probado y en uso usa IA para predecir el crimen. Los datos analizan la cantidad de delitos cometidos por un individuo con la ayuda de otros y la cantidad de delitos cometidos por personas del grupo social de ese individuo. El resultado de las pruebas mostró que había serias preguntas éticas para responder y que la tasa de fracaso significaba arrestar a personas inocentes.“ Un grupo de investigadores está comercializando en silencio un detector de mentiras impulsado por inteligencia artificial, que esperan sea el futuro de la seguridad del aeropuerto. Discern Science International es la nueva empresa detrás de una herramienta de detección de engaños llamada Avatar, que cuenta con un guardia de fronteras virtual que hace preguntas a los viajeros. La máquina, que ha sido probada por los servicios fronterizos y en los aeropuertos, está diseñada para hacer que el proceso de inspección en la seguridad fronteriza sea más eficiente y eliminar a las personas con intenciones peligrosas o ilegales con mayor precisión de lo que pueden hacer los guardias humanos ".

Martin Innes , director del Instituto de Investigación de Crimen y Seguridad de la Universidad de Cardiff, Reino Unido, dice que es "escéptico" de que el sistema prediga de manera confiable los delitos a nivel individual. La herramienta probablemente será más útil para localizar comunidades en riesgo en general, dice.

La policía de Northumbria está llevando a cabo un plan piloto que utiliza EyeDetect para medir la rehabilitación de los delincuentes sensuales. No pasará mucho tiempo antes de que tales sistemas se amplíen hasta el punto de que el uso de sistemas de detección de mentiras de IA se pueda usar en todos los asuntos de la toma de decisiones diaria.

En un reciente artículo de Guardian: " La carrera para crear un detector de mentiras perfecto ", el autor pregunta:

La pregunta más importante a considerar es si esas tecnologías se usan realmente, ¿qué efecto tendrá eso en la vida diaria para todos nosotros? La sociedad humana está organizada por todo tipo de factores diferentes y verse obligados a decir la verdad suena bien si todos lo hacen, pero aquellos que diseñan y controlan estos sistemas pueden estar exentos al igual que los agentes de la ley e incluso los políticos que autorizan su uso. . ¿Te imaginas herramientas avanzadas como estas en manos de líderes populistas aferrados al poder en un mundo lleno de noticias falsas y verdades posteriores para enmarcar a los opositores o disidentes?“ Pero a medida que herramientas como EyeDetect se infiltran en más y más áreas de la vida pública y privada, hay preguntas urgentes que deben responderse sobre su validez científica y uso ético. En nuestra era de alta vigilancia y ansiedad por las IAs todopoderosas, la idea de que una máquina pueda leer nuestros pensamientos más personales nos parece más plausible que nunca a nosotros como individuos, y a los gobiernos y corporaciones que financian la nueva ola de investigación de detección de mentiras . Pero, ¿qué pasa si los estados y los empleadores creen en el poder de una tecnología de detección de mentiras que demuestra ser profundamente sesgada, o que en realidad no funciona?

El otro problema es que los polígrafos se han utilizado para condenas por décadas. El primero fue en 1935 y desde entonces han seguido cientos de exoneraciones , y al final de este largo experimento, que ha demostrado ser un fracaso, su uso continúa y, lo que es peor, se está implementando en el Reino Unido.

La detección de mentiras es una frontera completamente nueva y las nuevas empresas se dirigen a ella en una era de seguridad nacional y doméstica, una forma de combatir los crecientes costos de vigilar las calles y luego buscar formas de tomar decisiones sobre la salud (cuestionarios sobre ejercicio, alimentos, alcohol ?), educación (áreas de captación?), empleo (¿razones para dejar el último empleador?) y todo tipo de vida normal.

Un número creciente de proyectos está utilizando IA para combinar múltiples fuentes de evidencia en una sola medida de engaño. ¿Te imaginas un sistema que te dé una calificación de engaño? El aprendizaje automático está acelerando la investigación del engaño al detectar patrones nunca vistos en una gran cantidad de datos. El artículo de The Guardian destaca que los científicos de la Universidad de Maryland, por ejemplo, han desarrollado un software que afirman que puede detectar el engaño de las imágenes de la corte con un 88% de precisión.

Discern Science , es un sistema de software, que cuenta con tecnología de entrevista automatizada que tiene como objetivo enviar un veredicto a un guardia fronterizo humano en 45 segundos, que puede hacer pasar al viajero o apartarlo para una evaluación adicional. Estos sistemas ya están en uso en Nogales en Arizona, en la frontera entre Estados Unidos y México, y con empleados federales en el aeropuerto Reagan cerca de Washington DC. Discern Science afirma tasas de precisión de entre 83% y 85%. Espera venderlos a aeropuertos, instituciones gubernamentales, centros de tras*porte público y estadios deportivos.“Los algoritmos detrás de tales herramientas están diseñados para mejorar continuamente con el tiempo y, en última instancia, pueden terminar basando sus determinaciones de culpabilidad e inocencia en factores que incluso los humanos que los han programado no comprenden . Estas pruebas se están probando en entrevistas de trabajo, en cruces fronterizos y en entrevistas policiales, pero a medida que se generalizan cada vez más, los grupos de derechos civiles y los científicos están cada vez más preocupados por los peligros que podrían desatar en la sociedad ".

Posteriormente , Frontex , la agencia fronteriza de la UE, llevó a cabo los ensayos y ahora está financiando un sistema competitivo llamado iBorderCtrl, con su propia guardia de fronteras virtual. Un aspecto de iBorderCtrl se basa en Silent Talker, una tecnología que ha estado en desarrollo en la Universidad Metropolitana de Manchester desde principios de la década de 2000. Silent Talker utiliza un modelo de IA para analizar más de 40 tipos de micro-gestos en la cara y la cabeza; solo necesita una cámara y una conexión a internet para funcionar. Este sistema tiene una tasa de precisión del 75%, y el equipo que desarrolló el algoritmo de IA llegó a decir que "No sabemos cómo funciona".

En julio de este año, el controvertido juicio de la Policía Metropolitana de Londres sobre tecnología de reconocimiento facial para detectar sospechosos no funcionó el 81% del tiempo , según los investigadores. Los investigadores de la Universidad de Essex dijeron que los problemas eran tan graves que el uso del reconocimiento facial por parte del Met debería detenerse de inmediato. Y, sin embargo, este sistema todavía está en funcionamiento y lo utilizan varias fuerzas policiales y contratistas privados.

Las tasas de precisión del 80-90% afirmadas por EyeDetect parecen impresionantes, pero aplicadas a la escala de un cruce fronterizo, llevarían a miles de personas inocentes a ser señaladas erróneamente por cada amenaza genuina que identificara. También podría significar que dos de cada 10 terroristas se deslizan fácilmente. Podría decirse que, por el contrario, ocho de cada diez no lo hacen, pero la evidencia de sistemas menos sofisticados como el reconocimiento facial nos dice que ese no será el caso.